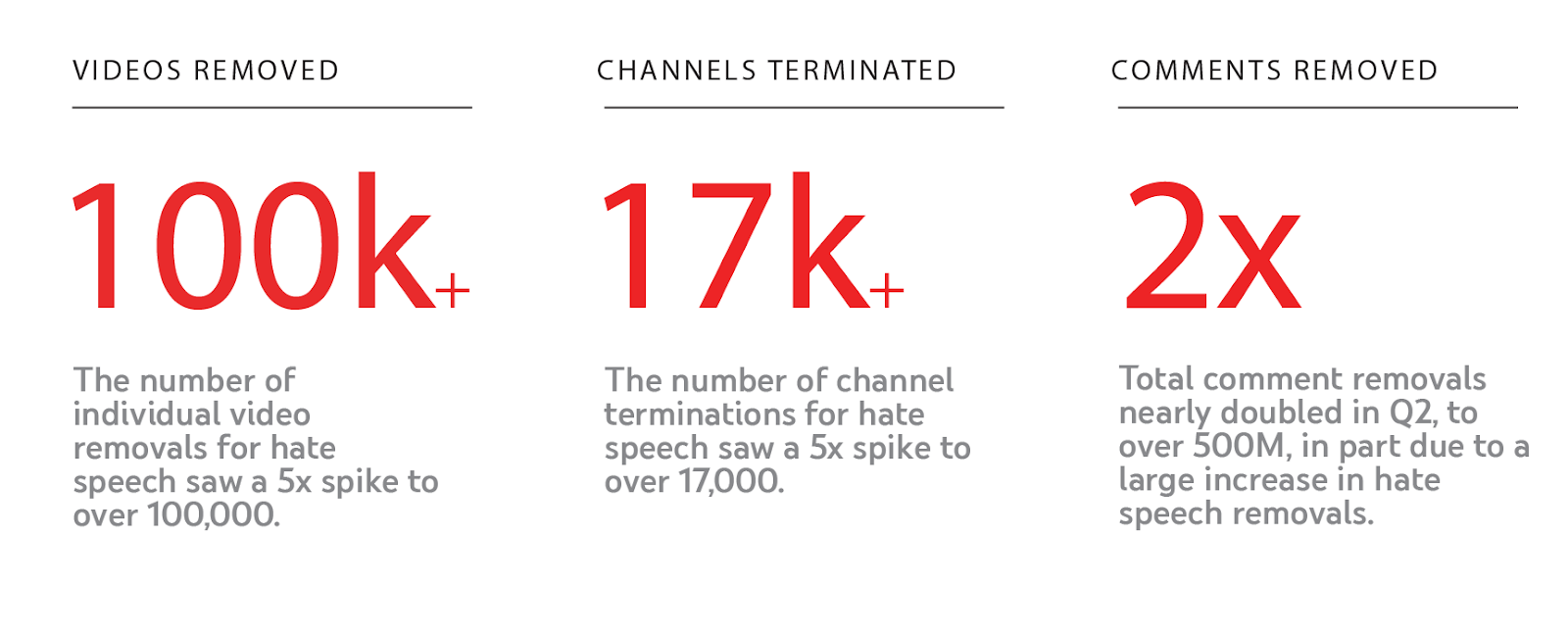

Por exemplo, o impacto profundo da actualização à política de incitação ao ódio, realizada em junho, já é evidente nos dados divulgados no Relatório de Aplicação das Regras da Comunidade do YouTube deste ultimo trimestre:

Os picos nos números de remoção devem-se, em parte, à remoção de comentários, vídeos e canais mais antigos que foram permitidos anteriormente.

Combinar automatização de processos com revisão humana. 87% dos 9 milhões de vídeos removidos no segundo trimestre de 2019 foram primeiramente sinalizados pelos nossos sistemas automatizados.

Abaixo post detalhado da Google:

Nos últimos anos, redobrámos os nossos esforços para cumprir com as nossas responsabilidades, enquanto preservamos a magia de uma plataforma aberta

O nosso trabalho tem sido organizado em torno de quatro princípios:

Nos próximos meses, iremos divulgar mais detalhes sobre o trabalho que fazemos de acordo com cada um destes princípios: Remover, Reduzir, Erguer e Recompensar. O primeiro post é focado no principio Remover. Removemos conteúdo nocivo desde o primeiro dia do YouTube mas o nosso investimento neste domínio aumentou nos últimos anos. A infografia abaixo reflecte as melhorias mais notáveis desde 2016. Deste trabalho em curso, nos últimos 18 meses, reduzimos as visualizações de vídeos que são removidos posteriormente por violarem as nossas políticas e continuamos a trabalhar para reduzir ainda mais este mesmo número.

Desenvolvimento de políticas para uma plataforma global

Antes de removermos o conteúdo que viola as nossas políticas, precisamos de garantir que a linha entre o que removemos e o que permitimos está no sítio correcto - com o objetivo de preservar a liberdade de expressão e, ao mesmo tempo, proteger e promover uma comunidade vibrante. Para isso, contamos com uma equipa dedicada ao desenvolvimento de políticas que analisa sistematicamente todas as nossas regras para garantir que estas estão atuais, que a nossa comunidade está segura e não asfixia o YouTube.

Depois de rever uma política, descobrimos geralmente que mudanças estruturais não são necessárias, mas, mesmo assim, conseguimos identificar tópicos vagos ou confusos para a comunidade. E por isso, muitas das atualizações feitas são, na verdade, esclarecimentos às diretrizes existentes. Por exemplo, no início deste ano, fornecemos mais detalhes sobre quando consideramos um "desafio" demasiado perigoso para o YouTube. Desde 2018, fizemos dezenas de atualizações nas nossas directrizes de aplicação.

Outras vezes, para questões particularmente complexas, podemos passar vários meses a desenvolver uma nova política. Durante esse período, consultamos especialistas externos e criadores do YouTube para entender como a nossa política atual pode estar aquém e levamos também em consideração diferenças regionais para garantir que as alterações propostas podem ser aplicadas de maneira justa e de forma global.

A nossa atualização do discurso de ódio representou uma destas mudanças estruturais nas nossas políticas. Passámos meses a desenvolver cuidadosamente a política e a trabalhar com as nossas equipas para as formações e as ferramentas necessárias para a aplicar. A política foi lançada no início do passado mês de junho e, à medida que as nossas equipas revêem e removem mais conteúdo de acordo com a nova política, a nossa detecção automática melhora proporcionalmente. Embora possa levar meses para incrementar a aplicação de uma nova política, o impacto profundo da atualização à política de incitação ao ódio, realizada em junho, já é evidente nos dados divulgados no Relatório de Aplicação das Regras da Comunidade do YouTube deste ultimo trimestre:

Os picos nos números de remoção devem-se, em parte, à remoção de comentários, vídeos e canais mais antigos que foram permitidos anteriormente. Em abril de 2019, anunciámos que também estamos a trabalhar para atualizar a nossa política sobre assédio, incluindo assédio de criador contra criador. Nos próximos meses, vamos partilhar os desenvolvimentos deste trabalho.

Utilizar máquinas para sinalizar maus conteúdos

Depois de definir uma política, confiamos numa combinação de pessoas e de tecnologia para sinalizar o conteúdo para as nossas equipas de revisão. Às vezes, usamos hashes (ou "impressões digitais") para apanhar cópias de conteúdos conhecido com infracções e mesmo antes de serem disponibilizados para visualização. Para alguns conteúdos, como imagens de abuso sexual infantil (CSAI) e vídeos de recrutamento de terroristas, contribuímos para bancos de dados partilhados de hashes para aumentar o volume de conteúdo que as nossas máquinas conseguem capturar no momento do carregamento.

Em 2017, expandimos a nossa tecnologia de machine learning para ajudar a detectar conteúdo - que potencialmente possa infringir as políticas - e a enviá-lo para análise humana. A tecnologia de Machine learning é adequada para detectar padrões, o que nos ajuda a encontrar conteúdo semelhante (mas não exatamente o mesmo) a outro conteúdo que já removemos, mesmo antes de ser visualizado. Estes sistemas são particularmente eficazes na sinalização de conteúdo com a mesma aparência, como spam ou conteúdo adulto. As máquinas também podem ajudar a sinalizar discursos de ódio e outros conteúdos infractores mas estas categorias são altamente dependentes do contexto e destacam a importância da revisão humana para tomar decisões diferentes. Ainda assim, mais de 87% dos 9 milhões de vídeos removidos no segundo trimestre de 2019 foram primeiramente sinalizados pelos nossos sistemas automatizados.

Estamos a investir significativamente nestes sistemas de detecção automáticos e as nossas equipas de engenheiros continuam a actualizá-los e a melhorá-los mensalmente. Por exemplo, a atualização dos nossos sistemas de detecção de spam no segundo trimestre de 2019 levou a um aumento de mais de 50% no número de canais que encerrámos por violarem as nossas políticas de spam.

Remoção de conteúdo antes que seja amplamente visualizado

Esforçamo-nos ao máximo para garantir que o conteúdo que viola as nossas regras não é amplamente exibido ou mesmo visualizado, antes de ser removido. Como mostrado acima, as melhorias nos nossos sistemas de sinalização automática ajudaram-nos a detectar e a rever o conteúdo antes mesmo de ser sinalizado pela nossa comunidade e, consequentemente, mais de 80% desses vídeos com sinalização automática foram removidos antes de receber uma única visualização no segundo trimestre de 2019.

Também reconhecemos que a melhor maneira de remover rapidamente o conteúdo é antecipar problemas antes que estes surjam. Em janeiro de 2018 criámos a equipa Intelligence Desk, que monitoriza notícias, redes sociais e relatórios de utilizadores com o objectivo de detectar novas tendências em torno de conteúdo inapropriado. Esta equipa também trabalha para garantir que todas as nossas equipas estão preparadas para responder a estas mesmas tendências antes que possam ganhar escala e algo preocupante.

Estamos determinados em continuar a reduzir a exposição a vídeos que violam as nossas políticas. Por isso, na Google, reunimos mais de 10.000 pessoas para detectar, rever e remover conteúdo que viola as nossas políticas. Devido à nossa capacidade de remover rapidamente este conteúdo, os vídeos que violam as nossas políticas representam uma fração de um por cento das visualizações no YouTube.

Por exemplo, os quase 30.000 vídeos que removemos por discurso de ódio no último mês representam o equivalente a 3% das visualizações de vídeo de tricot no mesmo período.

Na semana passada, atualizámos o nosso Relatório de Aplicação das Diretrizes da Comunidade, um relatório trimestral que fornece informações adicionais sobre a quantidade de conteúdo que removemos do YouTube, o porquê de ter sido removido e como foi detectado pela primeira vez. Este relatório demonstra como a tecnologia implementada nos últimos anos ajudou a remover conteúdo prejudicial do YouTube mais rapidamente do que nunca. Este relatório também destaca como a experiência humana ainda é uma componente crítica dos esforços de fiscalização à medida que trabalhamos para desenvolver políticas ponderadas, rever conteúdos com cuidado e para implementar com responsabilidade a nossa tecnologia de machine learning.

- 100 mil vídeos de discurso de ódio removidos

- 17 000 canais encerrados por incitação ao ódio

- Mais de 500 milhões de comentários apagados com conteúdo ofensivo e de ódio

Os picos nos números de remoção devem-se, em parte, à remoção de comentários, vídeos e canais mais antigos que foram permitidos anteriormente.

Combinar automatização de processos com revisão humana. 87% dos 9 milhões de vídeos removidos no segundo trimestre de 2019 foram primeiramente sinalizados pelos nossos sistemas automatizados.

Abaixo post detalhado da Google:

Nos últimos anos, redobrámos os nossos esforços para cumprir com as nossas responsabilidades, enquanto preservamos a magia de uma plataforma aberta

O nosso trabalho tem sido organizado em torno de quatro princípios:

Nos próximos meses, iremos divulgar mais detalhes sobre o trabalho que fazemos de acordo com cada um destes princípios: Remover, Reduzir, Erguer e Recompensar. O primeiro post é focado no principio Remover. Removemos conteúdo nocivo desde o primeiro dia do YouTube mas o nosso investimento neste domínio aumentou nos últimos anos. A infografia abaixo reflecte as melhorias mais notáveis desde 2016. Deste trabalho em curso, nos últimos 18 meses, reduzimos as visualizações de vídeos que são removidos posteriormente por violarem as nossas políticas e continuamos a trabalhar para reduzir ainda mais este mesmo número.

Desenvolvimento de políticas para uma plataforma global

Antes de removermos o conteúdo que viola as nossas políticas, precisamos de garantir que a linha entre o que removemos e o que permitimos está no sítio correcto - com o objetivo de preservar a liberdade de expressão e, ao mesmo tempo, proteger e promover uma comunidade vibrante. Para isso, contamos com uma equipa dedicada ao desenvolvimento de políticas que analisa sistematicamente todas as nossas regras para garantir que estas estão atuais, que a nossa comunidade está segura e não asfixia o YouTube.

Depois de rever uma política, descobrimos geralmente que mudanças estruturais não são necessárias, mas, mesmo assim, conseguimos identificar tópicos vagos ou confusos para a comunidade. E por isso, muitas das atualizações feitas são, na verdade, esclarecimentos às diretrizes existentes. Por exemplo, no início deste ano, fornecemos mais detalhes sobre quando consideramos um "desafio" demasiado perigoso para o YouTube. Desde 2018, fizemos dezenas de atualizações nas nossas directrizes de aplicação.

Outras vezes, para questões particularmente complexas, podemos passar vários meses a desenvolver uma nova política. Durante esse período, consultamos especialistas externos e criadores do YouTube para entender como a nossa política atual pode estar aquém e levamos também em consideração diferenças regionais para garantir que as alterações propostas podem ser aplicadas de maneira justa e de forma global.

A nossa atualização do discurso de ódio representou uma destas mudanças estruturais nas nossas políticas. Passámos meses a desenvolver cuidadosamente a política e a trabalhar com as nossas equipas para as formações e as ferramentas necessárias para a aplicar. A política foi lançada no início do passado mês de junho e, à medida que as nossas equipas revêem e removem mais conteúdo de acordo com a nova política, a nossa detecção automática melhora proporcionalmente. Embora possa levar meses para incrementar a aplicação de uma nova política, o impacto profundo da atualização à política de incitação ao ódio, realizada em junho, já é evidente nos dados divulgados no Relatório de Aplicação das Regras da Comunidade do YouTube deste ultimo trimestre:

Os picos nos números de remoção devem-se, em parte, à remoção de comentários, vídeos e canais mais antigos que foram permitidos anteriormente. Em abril de 2019, anunciámos que também estamos a trabalhar para atualizar a nossa política sobre assédio, incluindo assédio de criador contra criador. Nos próximos meses, vamos partilhar os desenvolvimentos deste trabalho.

Utilizar máquinas para sinalizar maus conteúdos

Depois de definir uma política, confiamos numa combinação de pessoas e de tecnologia para sinalizar o conteúdo para as nossas equipas de revisão. Às vezes, usamos hashes (ou "impressões digitais") para apanhar cópias de conteúdos conhecido com infracções e mesmo antes de serem disponibilizados para visualização. Para alguns conteúdos, como imagens de abuso sexual infantil (CSAI) e vídeos de recrutamento de terroristas, contribuímos para bancos de dados partilhados de hashes para aumentar o volume de conteúdo que as nossas máquinas conseguem capturar no momento do carregamento.

Em 2017, expandimos a nossa tecnologia de machine learning para ajudar a detectar conteúdo - que potencialmente possa infringir as políticas - e a enviá-lo para análise humana. A tecnologia de Machine learning é adequada para detectar padrões, o que nos ajuda a encontrar conteúdo semelhante (mas não exatamente o mesmo) a outro conteúdo que já removemos, mesmo antes de ser visualizado. Estes sistemas são particularmente eficazes na sinalização de conteúdo com a mesma aparência, como spam ou conteúdo adulto. As máquinas também podem ajudar a sinalizar discursos de ódio e outros conteúdos infractores mas estas categorias são altamente dependentes do contexto e destacam a importância da revisão humana para tomar decisões diferentes. Ainda assim, mais de 87% dos 9 milhões de vídeos removidos no segundo trimestre de 2019 foram primeiramente sinalizados pelos nossos sistemas automatizados.

Estamos a investir significativamente nestes sistemas de detecção automáticos e as nossas equipas de engenheiros continuam a actualizá-los e a melhorá-los mensalmente. Por exemplo, a atualização dos nossos sistemas de detecção de spam no segundo trimestre de 2019 levou a um aumento de mais de 50% no número de canais que encerrámos por violarem as nossas políticas de spam.

Remoção de conteúdo antes que seja amplamente visualizado

Esforçamo-nos ao máximo para garantir que o conteúdo que viola as nossas regras não é amplamente exibido ou mesmo visualizado, antes de ser removido. Como mostrado acima, as melhorias nos nossos sistemas de sinalização automática ajudaram-nos a detectar e a rever o conteúdo antes mesmo de ser sinalizado pela nossa comunidade e, consequentemente, mais de 80% desses vídeos com sinalização automática foram removidos antes de receber uma única visualização no segundo trimestre de 2019.

Também reconhecemos que a melhor maneira de remover rapidamente o conteúdo é antecipar problemas antes que estes surjam. Em janeiro de 2018 criámos a equipa Intelligence Desk, que monitoriza notícias, redes sociais e relatórios de utilizadores com o objectivo de detectar novas tendências em torno de conteúdo inapropriado. Esta equipa também trabalha para garantir que todas as nossas equipas estão preparadas para responder a estas mesmas tendências antes que possam ganhar escala e algo preocupante.

Estamos determinados em continuar a reduzir a exposição a vídeos que violam as nossas políticas. Por isso, na Google, reunimos mais de 10.000 pessoas para detectar, rever e remover conteúdo que viola as nossas políticas. Devido à nossa capacidade de remover rapidamente este conteúdo, os vídeos que violam as nossas políticas representam uma fração de um por cento das visualizações no YouTube.

Por exemplo, os quase 30.000 vídeos que removemos por discurso de ódio no último mês representam o equivalente a 3% das visualizações de vídeo de tricot no mesmo período.

Na semana passada, atualizámos o nosso Relatório de Aplicação das Diretrizes da Comunidade, um relatório trimestral que fornece informações adicionais sobre a quantidade de conteúdo que removemos do YouTube, o porquê de ter sido removido e como foi detectado pela primeira vez. Este relatório demonstra como a tecnologia implementada nos últimos anos ajudou a remover conteúdo prejudicial do YouTube mais rapidamente do que nunca. Este relatório também destaca como a experiência humana ainda é uma componente crítica dos esforços de fiscalização à medida que trabalhamos para desenvolver políticas ponderadas, rever conteúdos com cuidado e para implementar com responsabilidade a nossa tecnologia de machine learning.

Post A Comment:

0 comments: